عناوین محتوا

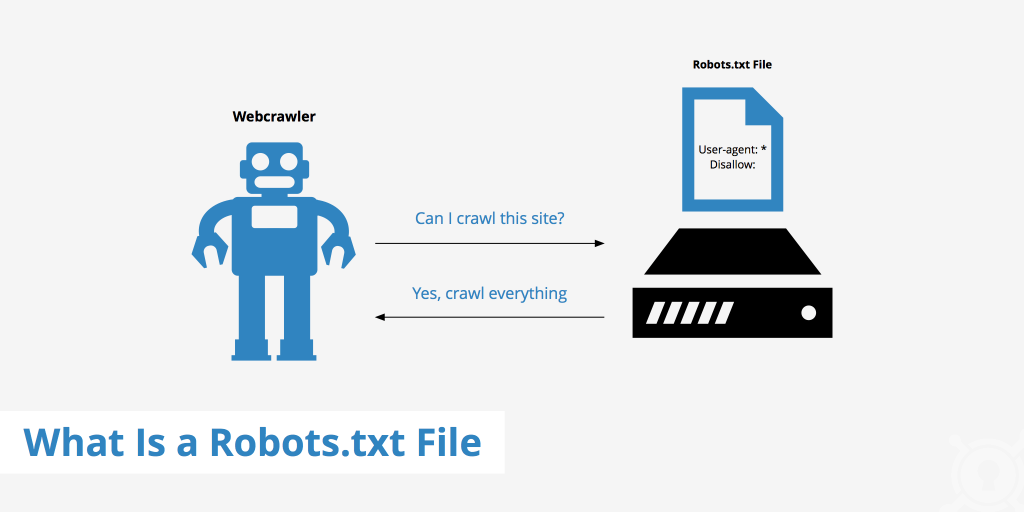

فایل robots.txt چیست؟

فایل robots.txt بخشی از پروتکل REP است که به ربات های گوگل اجازه بررسی و خزیدن (crawl) کردن یک صفحه یا عکس را نمیدهد. به زبان ساده تر فایل robots.txt یعنی به ربات های گوگل راهنمایی میکنه که این صفحه را نبین.

پروتکل REP چیست؟

پروتکل REP به استاندار سازی خزیدن و جستجوی ربات های گوگل در صفحات وبسایت و نحوه نمایش آنها به کاربر می پردازد.

فایل Robots.txt چگونه عمل میکند؟

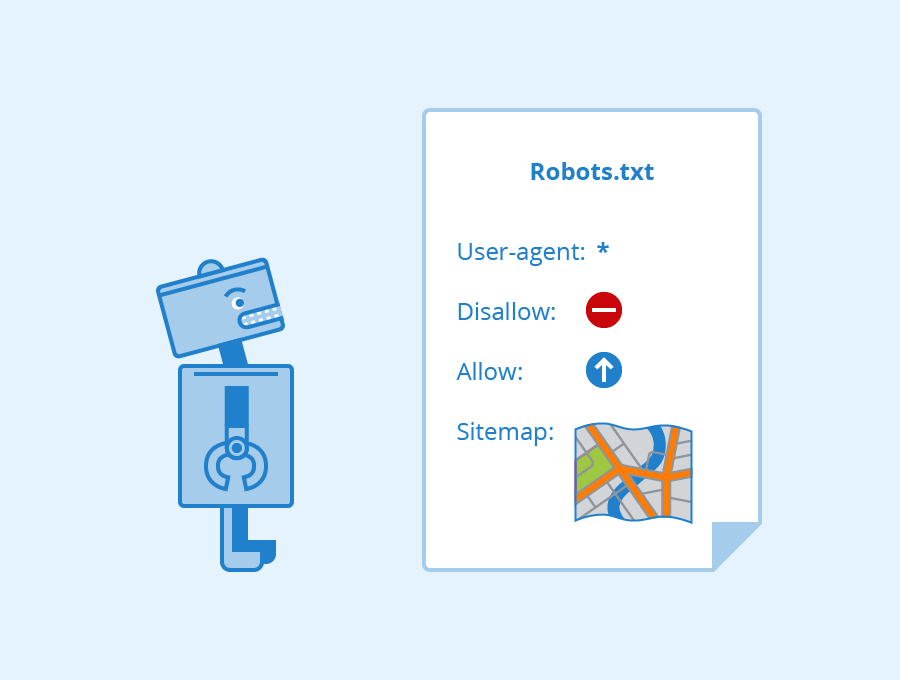

این فایل شامل دستوراتی ساده مثل user agernt ،allow ،disallow ،sitemap است که البته ترتیب قرار گرفتن این دستورات مهم است.

مثالی از نحوه نوشتن کلی این فایل:

/: User-agent

/ : Disallow

/ : allow

sitemap: https://seoinja.com/sitemap_index.xml

از خط اول شروع به توضیح می نماییم.

User_agent :

این دستور به ربات های گوگل اشاره میکند. وقتی جلوی این دستور علامت * گذاشته شود یعنی مقصود ما تمام ربات های گوگل است اما اگر منظور ما یک ربات یا ربات های خاصی بود باید نام آن را بنویسیم.

مثلا:

User_agent :Bingbot

disallow : دستور

این دستور بررسی میکند که ربات مورد نظر شما کدام صفحات یا فایل ها را نبیند. نکته خیلی مهم که بسیاری از وب مستران رعایت نمیکنند این است که اگر شما همانطور که در مثال بالا دیدید بعد از disallow علامت / را بگذارید و بعد آن چیزی ننویسید یعنی ربات محترم شما هیچ جای وبسایت مرا نبین.

طبیعتا این اتفاق برای وب سایت شما بسیار بد خواهد شد چون ربات های گوگل در اثر خزیدن در سایت شما به آن ارزش و اعتبار میدهند و در صفحه نتایج آن را نشان میدهند و اگر هیچ یک از صفحات شما را نبینند به سایت شما رنک نمیدهند.

نحوه نوشتن اشتباه disallow :/

نحوه نوشتن صحیح disallow :/products/content

Disallow:

این دستور یعنی تمام صفحات وب سایت مرا ببین.

آیا در فایل robots.txt فقط آدرس صفحات را می توانیم بنویسیم؟

بسیاری از کاربران این سوال را دارند و جواب ما خیر است. شما هر فایلی در سایتتان اعم از عکس و فایل هایی که به فرمت pdf هستند و طبقه بندی های را میتوانید در این فایل قرار دهید.

چه چیزهایی را باید در فایل robots.txt قرار دهیم؟

هر دایرکتوری یا دسته ای که بخواهیم از دید خزنده های موتور جستجو پنهان کنیم .نمونه هایی از این دسته ها را ذکر میکنیم:

صفحاتی که دارای محتوای تکراری هستند

صفحات محصولات یا خدمات داینامیک

صفحه چت و نظرات کاربران

صفحات مدیریت

صفحات تشکر از مشتری

چرا استفاده از فایل robuts.txt در سئو مهم است؟

برای اینکه سایتتان را بهینه کنید تا در صفحه نتایج موتورهای جستجو رتبه خوبی کسب کنید باید بدانید چه مطالبی را به خزنده های گوگل نشان دهید و چه مطالبی را نشان ندهید. مثلا ما اشاره کردیم که بخش نظرات کاربران بهتر است داخل فایل robots.txt قرار بگیرد. چرا؟

چون ممکن است بعضی کاربران بک لینک هایی از سایت خودشان را در کامنت ها قرار دهند و اگر این لینک ها اسپم باشند و ربات های گوگل آنها را شناسایی کنند آن وقت سایت شما نیز اسپم شناسایی خواهد شد. مهم تر از داشتن فایل robots.txt نحوه درست استفاده کردن از آن است. باید نکاتی که در ابتدای این مقاله گفته شد را جدی بگیرید.

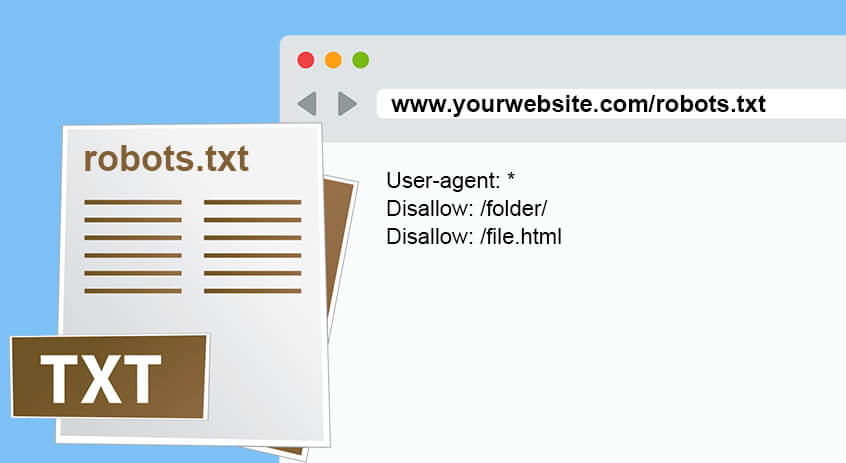

فرمت صحیح نوشتن فایل robots.txt

ابزار SEMRUSH فرمت درست این فایل را توضیح میدهد

User-agent → Disallow → Allow → Host → Sitemap

این ترکیب باعث میشود تا ربات های موتورهای جستجو به درستی یک پیج را خزش کنند.

User_agent : *

Disallow: /blog/page/

Disallow: /download/

Disallow: /blog/author

Disallow: /accounts/

Disallow: /blog/*?img=*

Allow: /researchtools/ose/$

Allow: /researchtools/ose/pages$

Sitemap :https://seoinja.com/sitemap_index.xml

نکته: کاراکتر * یعنی هر دنباله ای از کاراکتر های دیگرکه بسته به جایی که * آمده میتواند قبل یا بعد کلمه باشد.

کارکتر $ را وقتی به کار میبریم که میخواهیم یک url را به پایان برسانیم.

نکات مهم در نوشتن فایل robots.txt

این فایل فقط با حروف کوچک است. مثلا ROBOTS.TXT یا Robots.txt اشتباه است.

فایل robots.txt باید در دایرکتوری اصلی سایت باشد.

در نوشتن نام ربات گوگل یا نام صفحاتی که میخواهید آنها را پنهان کنید نباید اشتباه نوشتاری داشته باشید.

دسته ها و پیج های مختلف را در یک خط از دستور disallow نباید بنویسید بلکه آدرس هر پیج در هر خط جداگانه باشد.

مثال

Disallow :/Css/cgi_bins/images /:

این فرمت اشتباه هست و هر کدام باید در یک خط جدا بیاید.

Disallow: /css/

Disallow: /cgi_bins/

Disallow: /images/

اشتباه بعدی این است که جلوی دستور user_agent نباید خالی باشد. یا علامت * را بگذارید یا اسم ربات مورد نظرتان را بنویسید. برای اینکه موتورهای جستجو منظور شما را به طور درست درک کنند آدرس سایت خودتان را در host بنویسید.

Host: https://www.seoinja.com

لازم نیست لیست تمام فایل های یک دایرکتوری را در disallow های مختلف بنویسید. وقتی شما نام یک دایرکتوری را مینویسید تمام فایل هایش هاید میشوند.

بعضی اوقات نمیخواهید هیچ صفحه ای از چشم ربات های موتور جستجو پنهان بماند. بعضی ها فکر میکنند اگر دستور disallow را ننویسند مشکلشان حل میشود در صورتی که این طور نیست. دستور disallow باید در ساختار فایل robots.txt باشد. میتوانید برای این کار از دستور :disallow استفاده کنید .

گوگل در سال ۲۰۱۹ میلادی اعلام کرد دیگر در فایل های robots.txt فایل های no index را شناسایی نمیکند

user_agent: *

Disallow: /

Noindex: aboutus

استفاده ی درست

User_agent: *

Disallow: aboutus

فایل robots.txt را از کجا بیاوریم؟

اگر سیستم مدیریت محتوای شما وردپرس باشد ابزار Yoast هم این فایل و هم ویژگی های دیگر سئو سایت را دارد.

نتیجه گیری

همان طور که در مقاله عنوان کردیم برای کسب رتبه ی عالی در صفحه نتایج موتور جستجو باید بدانید چه چیزهایی را در معرض ایندکس کردن یا نکردن ربات های موتور جستجو قرار دهید. لازم نیست ربات ها زیر و بم وب سای شما را ببینند. با طرز استفاده درست از فایل robots.txt شما میتوانید به هدف خود نزدیک تر بشوید.

شرکت سئو اینجا در زمینه خدمات سئو سایت و مشاوره سئو برای کمک به شما آماده است.

بدون دیدگاه